近頃話題の大規模言語モデルのPhi-3-miniをWindowsPCで動かしてみました。

- OS:Windows 11

- GPU:RTX 4060 Ti (VRAM 8GB)

- WSLの中にあるdockerを使います

- OllamaとOpen WebUIを使います

Dockerの準備

WSLの中でDockerを動かします。インストール方法はこちらの記事で紹介しています。

OllamaとOpen WebUIの起動

起動させるものは2個あります。

Ollama

まずはOllamaです。使用方法は公式に載っていました。

CPUだけ使う場合とGPUを使う場合でdockerのコマンドが変わります。

#CPUだけ使う場合

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

#GPUを使う場合

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama私の場合は後者のコマンドを実行しました。

初回はイメージのダウンロードが走り、その後起動します。

起動後はコンソールには特に何も表示されません。シェルの入力待ち状態に戻ります。

Open WebUI

Open WebUIのページはこちらです。

実行するコマンドはこちら。

(スクロールが要るくらい長いですが、トリプルクリックで全選択できるはず)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainこちらも起動後には特に何も表示されませんが、それでOKです。

ブラウザでアクセス

起動したらブラウザで http://localhost:3000/ にアクセスします。ファイアウォールの設定を変えればLAN内の他のPCやスマホからもアクセスは可能だと思います。

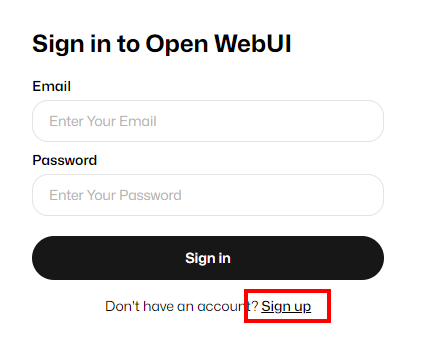

アクセス後は以下のような画面が出ます。

まずは Sign upします。メールアドレスとパスワードを入力します。

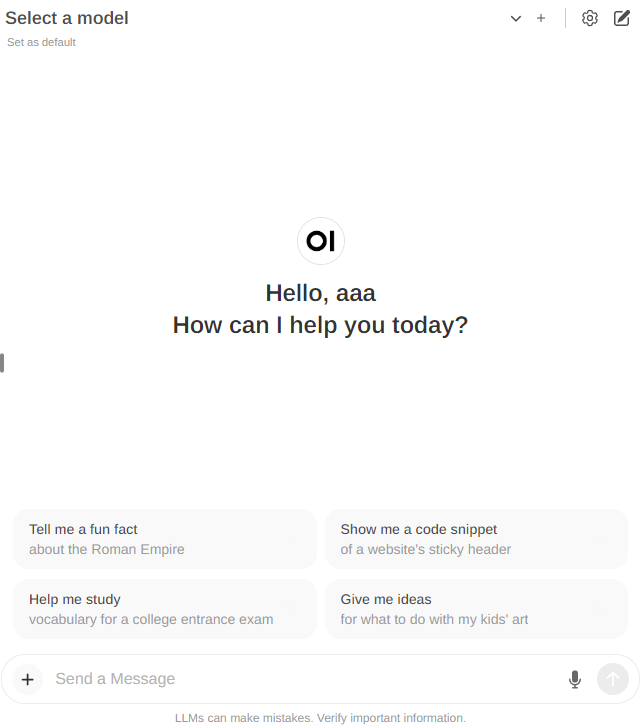

こちらはローカルの上でのアカウント作成なので、ここの情報がインターネットのどこかに行くわけではないと思われます。アカウントができると以下のようなChatGPT風の画面が表示されます。

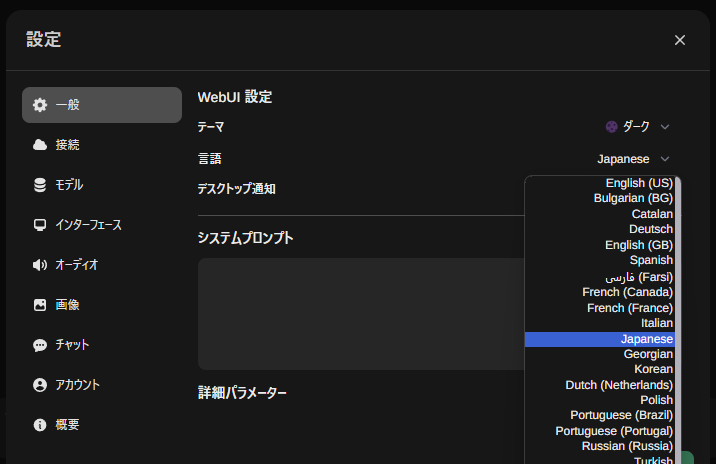

設定は右上の歯車です。ここでダークテーマにしたり日本語にしたりできます。

モデルのダウンロードと切り替え

モデルは上記の設定の中にあります。今回は phi3 と入力してダウンロードを実行します。phi3の場合はPhi-3-miniがダウンロードされます。

ここに入力できるモデル名はOllamaのページに一覧があります。

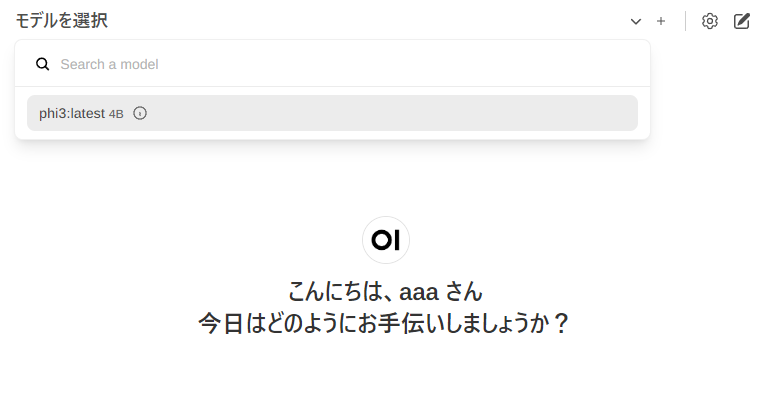

ダウンロードが終わったら設定画面を閉じ、チャット画面上部の「モデルを選択」でphi3:latest 4Bを選択します。

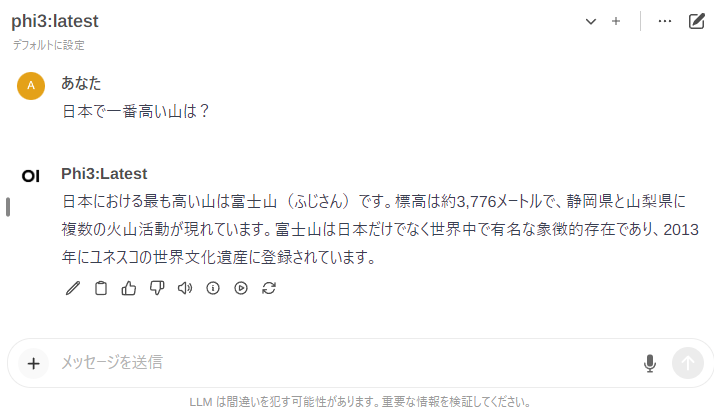

いよいよチャット実行

これで動かせる状態になりました。適当に質問してみます。

いい感じですね。それと応答速度が速いです。これを動かしている状態で、GPUメモリはタスクマネージャ読みで4.4GB使用していました。RTX 4060 Tiは8GBなのでAIには不向きと言われていますが、かなり余裕があり、動作も非常に速かったです。すごい!

まとめ

MicrosoftのPhi-3-miniをローカルPCのブラウザ上で動かす方法を解説しました。Dockerが動く状態であれば非常に簡単に試すことができますので、環境がある方はぜひ試してみてください。

コメント